数据是现代企业决策的核心资源,如何有效地管理和利用这些数据,成为了企业提升竞争力的关键。而在大数据分析的过程中,ETL(Extract, Transform, Load)工具起着至关重要的作用。它们帮助企业从不同的数据源中提取信息,进行清洗和转化,最后将数据加载到目标数据仓库中,从而实现高效的数据处理与分析。

本文将为您提供一个ETL工具入门教程,带您一步一步搭建自动化数据管道,帮助您掌握这一强大的数据处理工具。

什么是ETL?

ETL代表提取(Extract)、转换(Transform)和加载(Load)。它是一种用于数据集成的过程,帮助企业从多个来源获取数据、进行格式转化、并将其存储到目标数据库或数据仓库中。ETL工具通常应用于企业的数据仓库和大数据分析流程中,帮助整理和准备数据以供后续分析使用。

- 提取(Extract):从不同的数据源提取数据,数据源可能是结构化的(如数据库),也可能是非结构化的(如文本文件、网页等)。

- 转换(Transform):对提取的数据进行清洗、转换、合并和汇总等处理,使其符合目标系统的要求。转换可能包括格式化日期、去除重复数据、处理缺失值等。

- 加载(Load):将处理后的数据加载到目标数据仓库或数据库中,供业务人员和分析师使用。

为什么ETL对于数据分析如此重要?

随着企业数据的增加和种类的多样化,企业需要一个统一的框架来处理这些分散的数据。ETL工具的出现,使得从不同来源、不同格式的数据能够通过标准化流程被统一处理,方便后续的数据分析和决策。

使用ETL工具的好处包括:

- 数据质量保证:ETL过程中的数据清洗和转换步骤能够确保最终数据的质量,去除重复、错误或不一致的数据。

- 节省时间:自动化的数据管道能够大大减少人工处理的时间,提高工作效率。

- 提升决策能力:通过将数据从各个源头汇聚到一个集中的地方,ETL帮助企业获取更全面、更准确的分析结果,从而做出更具依据的决策。

ETL工具选择与搭建数据管道

1. 选择合适的ETL工具

选择合适的ETL工具对于成功实现自动化数据管道至关重要。目前市场上有许多ETL工具可以选择,常见的包括:

- 开源ETL工具:如Apache NiFi、Apache Airflow、Talend等。这些工具通常功能强大且灵活,适用于需要高度定制化的数据处理流程。

- 商业ETL工具:如Informatica PowerCenter、Microsoft SQL Server Integration Services(SSIS)、IBM DataStage等。这些工具通常有更多的企业级支持,适合大规模数据处理。

- 云端ETL工具:如AWS Glue、Google Cloud Dataflow等,这些工具便于在云环境中运行,具有很高的弹性和扩展性。

如果你是中小企业,想要寻找更适合的工具,DataFocus BI 提供了出色的BI解决方案,支持自动化数据提取与转化,同时与云端服务(如DataFocus Cloud)兼容,能为您提供无缝的数据分析体验。你可以根据业务需求选择SaaS服务或私有部署服务。

2. 搭建ETL数据管道

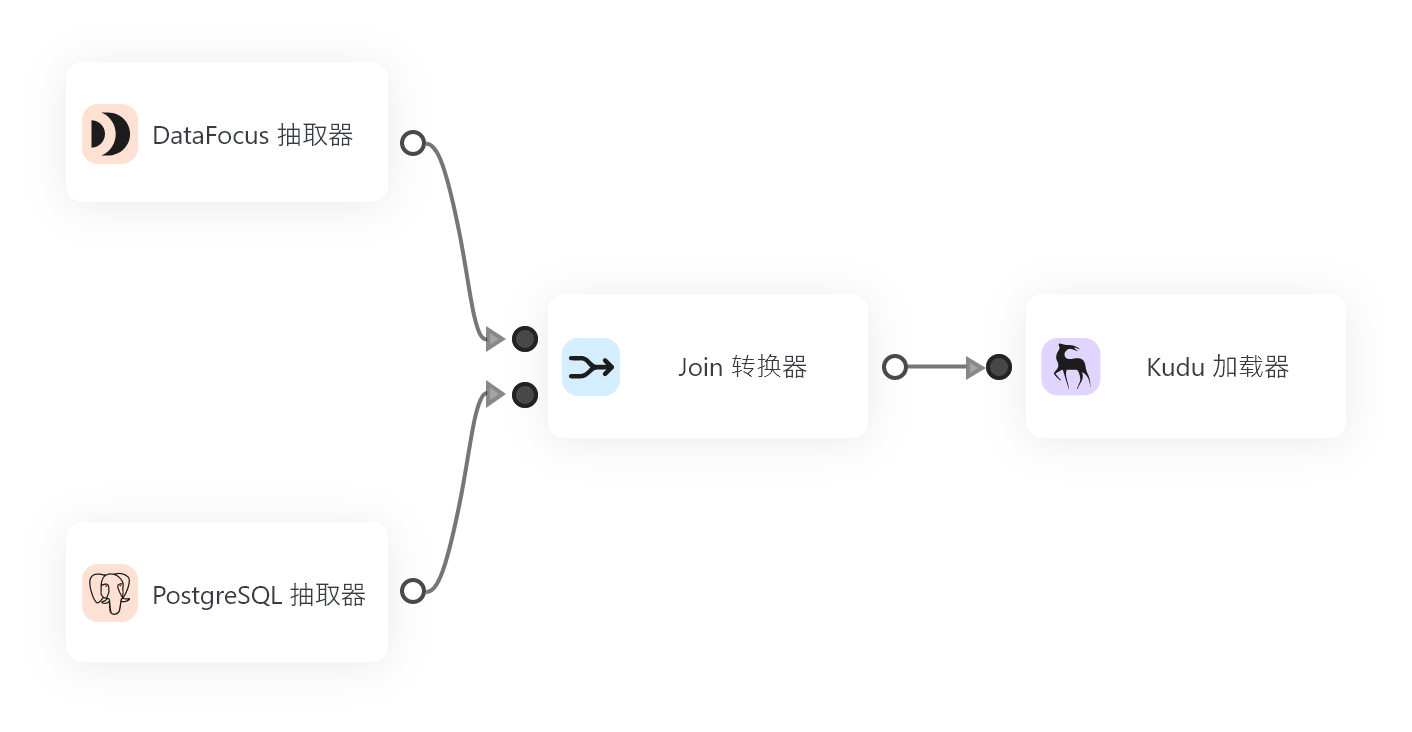

以DataFocus BI为例,下面是一个从零开始搭建自动化ETL数据管道的完整流程。

步骤一:数据提取(Extract)

需要明确从哪些数据源提取数据。常见的数据源包括:

- 数据库:如MySQL、PostgreSQL、SQL Server等。

- 文件系统:如CSV文件、Excel文件、JSON等。

- Web API:从第三方API或内部API提取数据。

- 流式数据:如Kafka、RabbitMQ等消息队列。

对于DataFocus Cloud,你可以通过其内置的连接器轻松连接各种数据源,无需编写大量代码。通过简单的配置,选择要提取的数据源和字段,系统就能自动化地提取所需数据。

步骤二:数据转换(Transform)

数据提取完成后,需要对数据进行转换。转换的过程包括但不限于以下操作:

- 数据清洗:去除重复数据、填补缺失值、修正格式不一致的数据等。

- 数据合并:从多个数据源中合并数据,创建一个统一的数据集。

- 数据映射:将字段或表格中的数据映射到目标数据仓库中的相应字段。

- 数据聚合:对数据进行汇总、计算或其他聚合操作,如计算总和、平均值、最大值等。

DataFocus BI支持高度灵活的转换操作,通过直观的界面和强大的计算能力,帮助用户轻松处理复杂的数据转换任务。例如,你可以使用内置的“查询编辑器”对数据进行过滤、分组和排序,确保数据满足后续分析的需求。

步骤三:数据加载(Load)

经过转换后的数据需要被加载到目标数据库或数据仓库中。加载的方式通常有两种:

- 全量加载:将所有的数据重新加载到目标系统中,适用于小规模数据或初次加载时。

- 增量加载:只加载更新的数据,减少处理时间和存储空间,适用于数据量较大且更新频繁的场景。

DataFocus Cloud提供了灵活的加载选项,支持全量和增量加载。其云端环境能够根据数据量自动扩展,确保加载过程的高效性和可靠性。

步骤四:自动化与调度

为了实现自动化数据管道,您需要定期或按需运行ETL任务。这可以通过调度任务来完成。

在DataFocus Cloud中,您可以通过内置的调度功能来设定ETL任务的运行时间和频率。例如,您可以设置每天凌晨运行数据提取与转换操作,确保数据始终保持最新状态。您可以通过“通知”功能,实时监控数据管道的执行情况,及时发现问题并进行修复。

3. 使用ETL工具提升数据管道的可靠性和性能

为了确保数据管道的高效性和稳定性,可以采取以下措施:

- 日志记录和监控:确保ETL工具能够记录详细的日志,并提供实时监控功能。这可以帮助您发现潜在的问题,并进行及时的调整和优化。

- 性能优化:对于大规模数据处理,您需要关注ETL任务的性能,合理规划计算资源,避免瓶颈和性能下降。

- 数据质量监控:自动化数据管道并不代表您可以忽视数据质量,定期对数据进行质量检查,确保输出的数据始终符合预期。

4. ETL工具的应用场景

ETL工具的应用场景非常广泛,包括但不限于以下几个领域:

- 数据仓库建设:通过ETL工具将分散在各个系统中的数据集中到一个数据仓库中,为企业提供更好的数据支持。

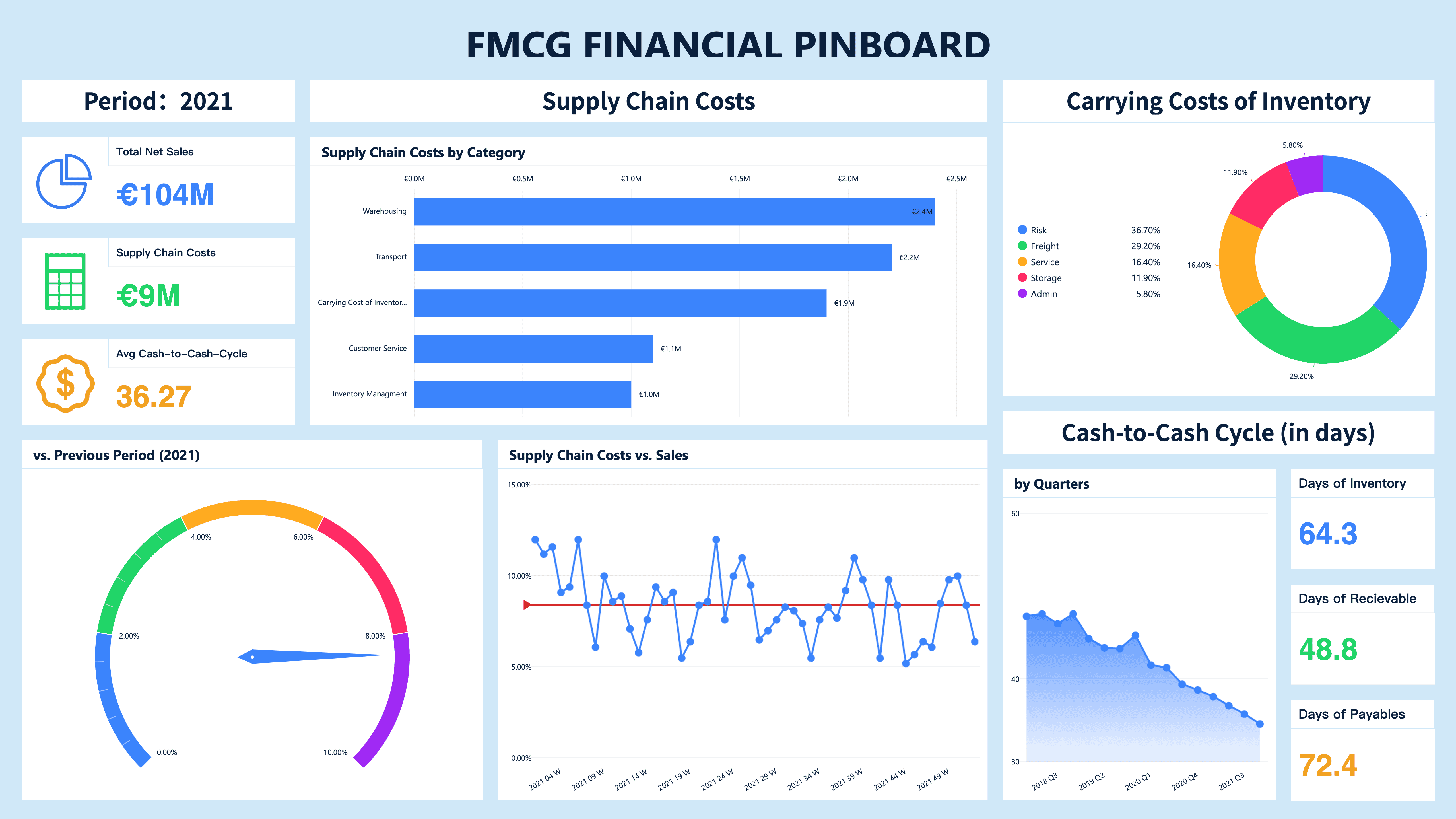

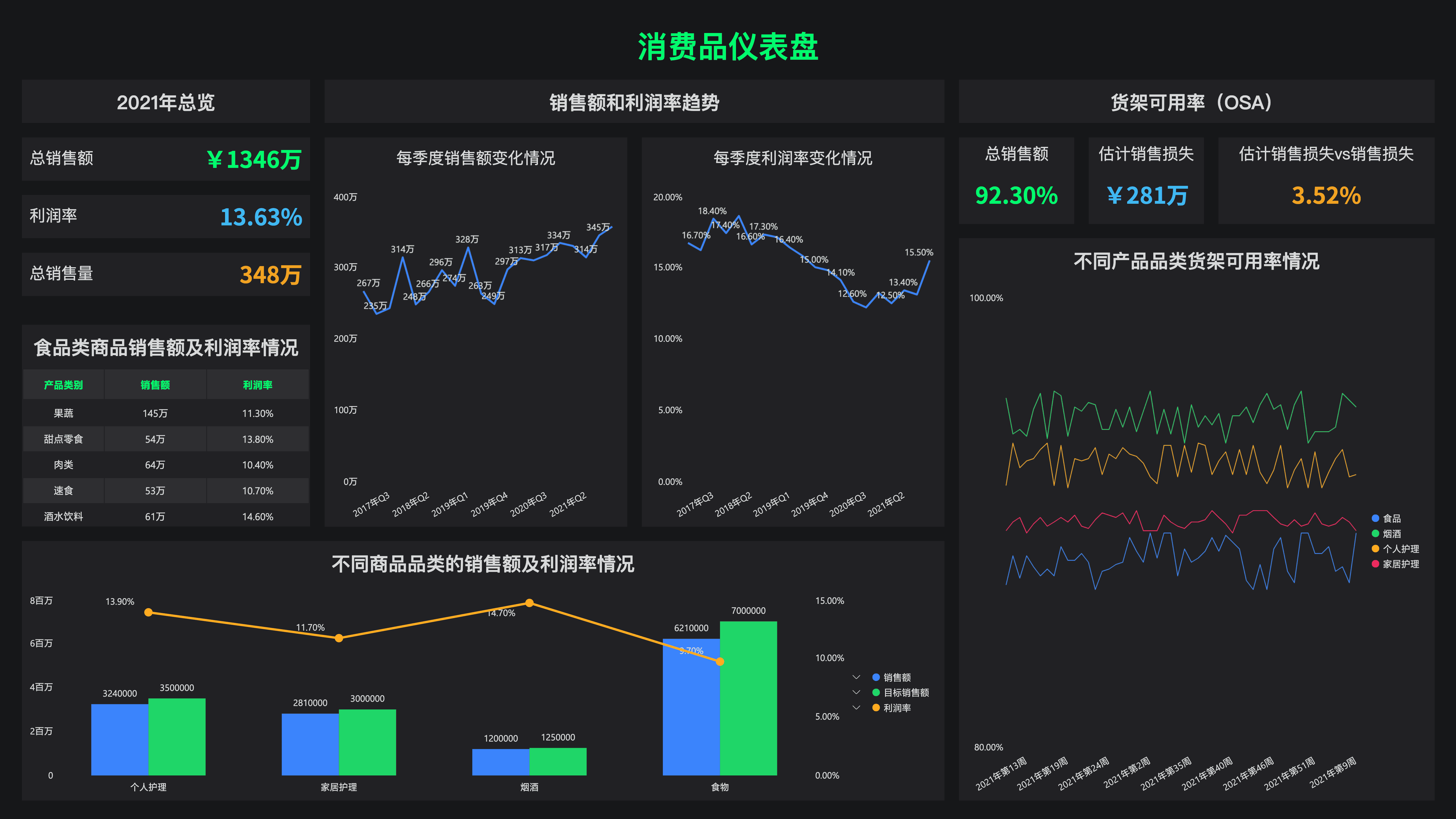

- 商业智能:通过ETL工具将不同来源的数据提取、转化并加载到BI系统中,支持数据分析和决策制定。

- 数据湖建设:将各种类型的数据(结构化、非结构化、半结构化)集中到数据湖中,便于后续分析。

- 实时数据处理:通过流式ETL工具,实现数据的实时处理和实时分析。

总结

ETL工具是现代数据处理和分析的基础,它通过提取、转换和加载过程帮助企业管理复杂的多源数据。通过自动化数据管道的构建,企业能够高效地整合数据,为决策提供坚实的数据支持。

如果你正在寻找一个易于使用、功能强大的ETL工具,DataFocus BI和DataFocus Cloud将是您的理想选择。它们提供了完整的ETL功能,支持自动化数据管道的搭建,帮助中小企业和大型企业提高数据处理的效率和质量。

希望这篇文章能帮助您更好地理解ETL工具,并为您搭建自动化数据管道提供一些实践指导。