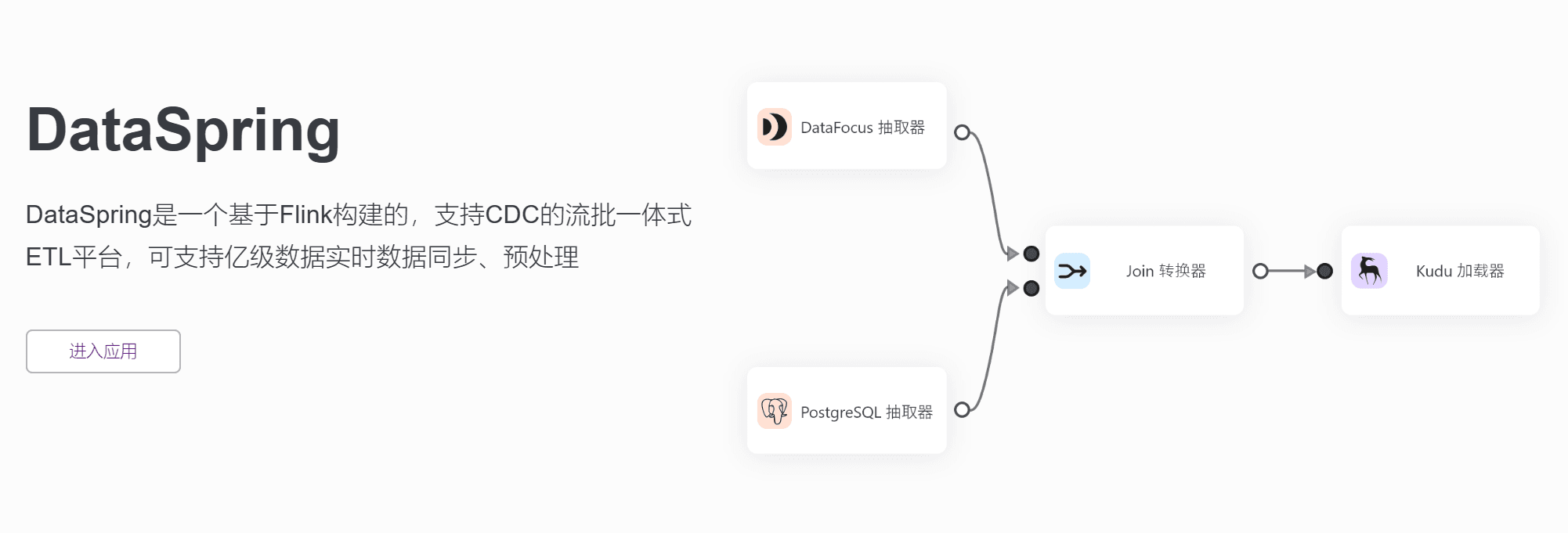

导语:作为数据分析师,数据预处理是必不可少的工作。而DataSpring平台提供了一种更快速、更准确的数据处理方法。本文将介绍DataSpring平台的优势和应用场景,让您了解该平台如何成为数据分析师的重要帮手。

作为数据分析师,一天中几乎80%的时间都是在进行数据预处理工作。为获得准确的数据洞察,分析师们不断将精力投入到数据预处理的工作上面。而这正是DataSpring流批一体式ETL平台所要解决的。

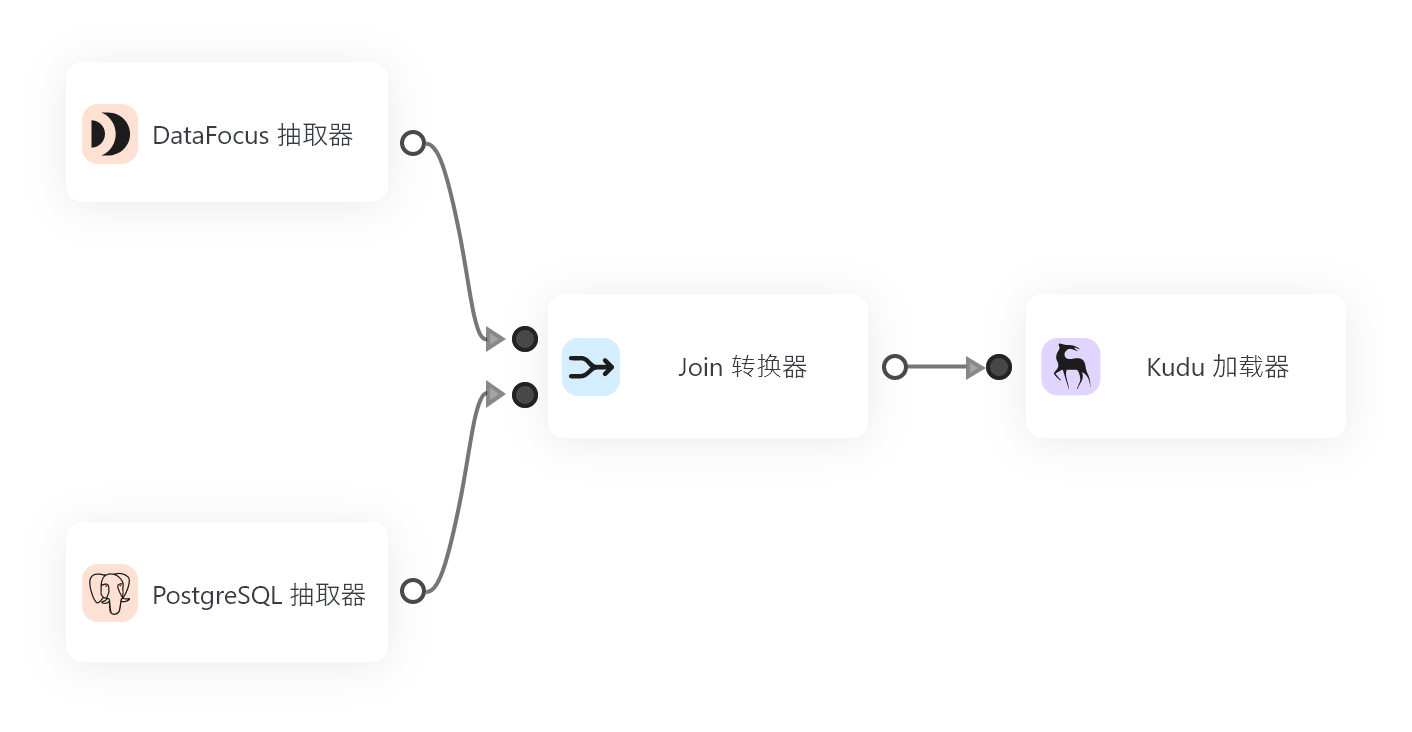

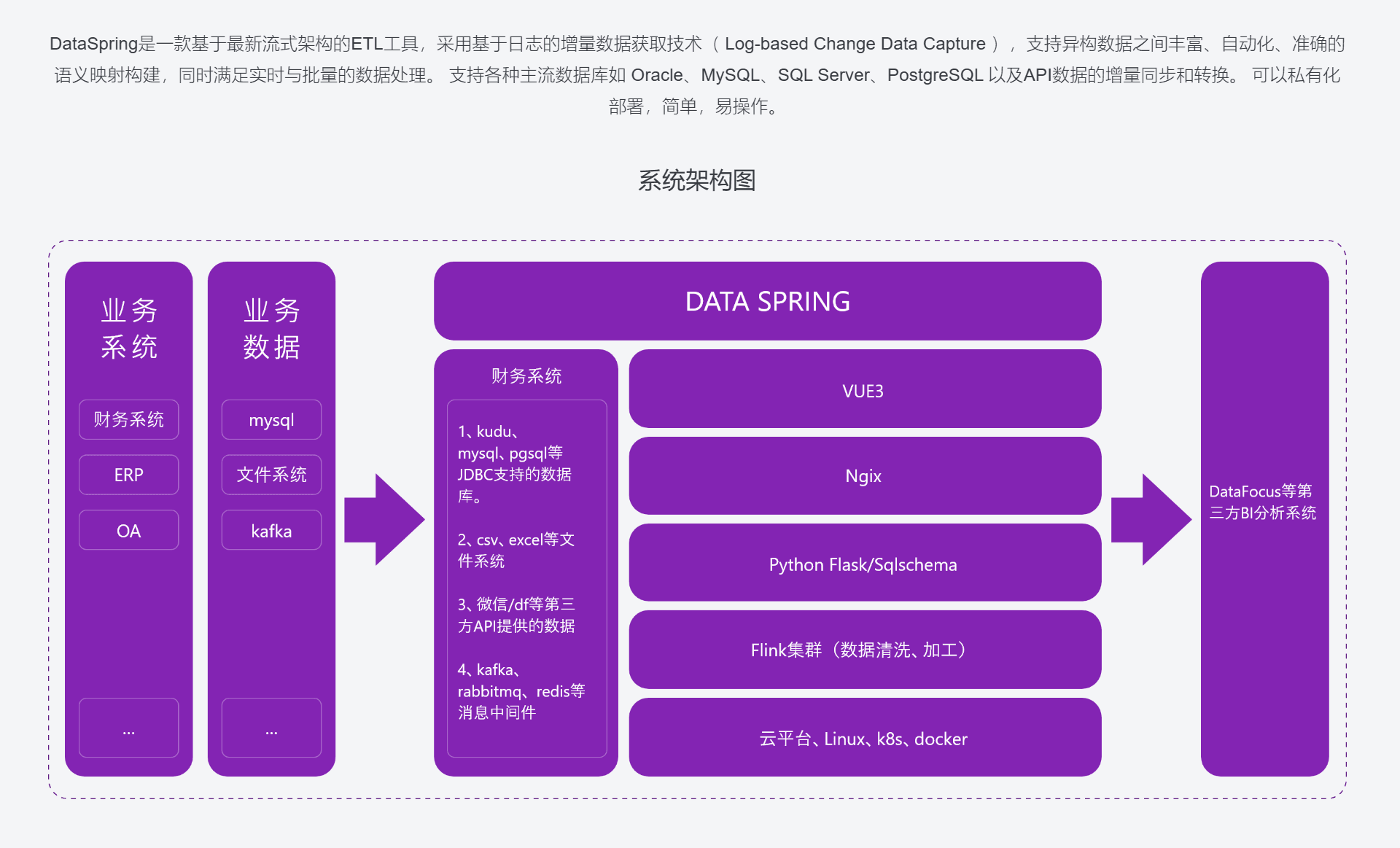

DataSpring平台是一个基于最新流式架构的ETL工具,采用基于日志的增量数据获取技术(Log-based Change Data Capture),支持异构数据之间丰富、自动化、准确的语义映射构建,同时满足实时与批量的数据处理。它可以支持各种主流数据库如Oracle、MySQL、SQL Server、PostgreSQL以及API数据的增量同步和转换。

对于一个数据分析师来说,做好数据处理工作是至关重要的。数据预处理通常涉及到数据清洗、过滤、去重、缺失值填补等复杂的操作,因此,需要花费大量的时间精力来完成这项工作。一个知名的数据科学家提出了“垃圾进,垃圾出”的观点,就是说如果在数据预处理的阶段没有做好工作,那么得到的结果就会受到影响,甚至变得毫无意义。对于这个问题,DataSpring平台提供了一种更快速、更准确的数据处理方法。

将数据同步到数据仓库中是数据分析师经常要面对的问题之一。而DataSpring平台可防止在数据抽取和转换时丢失数据或导致错误。它有很多优势:

(1)新架构的优势——相较于传统架构,在事件驱动应用中,数据和计算不分离,具有更高的吞吐和更低的延时。

(2)数据接入:支持常用关系型数据库数据接入,也支持API数据接入;

(3)批处理任务:定时任务完成批处理任务;

(4)流处理任务:基于CDC技术的实时流式数据接入;

(5)公式转换:可以通过预置公式,实现类似Excel函数的数据转换;

(6)自定义UDF算子:针对复杂的数据处理逻辑,也支持自定义基于python代码的UDF算子进行处理;

(7)定时任务:配置好的任务流支持做成定时任务:间隔多久执行、指定时间执行、周期循环执行;

(8)日志及用户管理:ETL管理界面提供操作日志查询、用户管理等通用模块;

(9)与DataFocus无缝集成:支持DFC会员中心的单点登录功能,且与DFC联合部署后,可以实现无缝的产品使用体验。

DataSpring平台不仅适用于各种形式和大小的数据集,而且还具有广泛的应用场景。

(1)实时计算:直播,传感器,双11活动数据的实时摄取,形成实时的监控大屏;

(2)实时数据抽取和清洗:将业务系统的数据经过抽取、清洗转换之后加载到数据仓库;

(3)事件驱动型应用:从服务器上报的消息中将 CPU、MEM、LOAD 信息分离出来做分析,然后触发自定义的规则进行报警。

总之,DataSpring ETL平台是一个高效、灵活、易扩展的ETL工具,适用于各种异构数据格式,实现了优秀的增量同步效果,能够帮助数据分析师节省大量数据预处理时间,为企业的商业决策赢得宝贵而准确的数据。在当前这个数据爆炸的时代,在你的数据中挖掘出优势所在,并用它来做出更好的决策,DataSpring平台将成为你重要的帮手!