“AI幻觉”——这个听起来颇具科幻色彩的词,却是所有投身于大型语言模型(LLM)应用开发团队的梦魇。在商业智能(BI)领域,这个问题的破坏力被指数级放大:一个错误的数字,一次偏离事实的归因,都可能导致企业做出错误的商业决策。当我们将AI引入BI,我们承诺的是效率与洞察,但如果答案的准确率只有70%,带来的究竟是助手,还是“灾难”?

这,就是我们DataFocus团队在打造新一代ChatBI产品时,必须翻越的第一座,也是最险峻的一座大山。本文将完整揭秘,我们如何通过一套技术“组合拳”,直面AI幻觉这一核心痛点,将产品的答案准确率从最初不稳定的70%提升至业界领先的95%以上,最终赢得客户的绝对信任。

一、最初的困境:70%准确率背后的信任危机

在项目初期,我们和许多同行一样,对LLM的强大能力感到兴奋。我们基于先进的Text-to-SQL技术,推出了产品的雏形——Focus Search。用户只需用自然语言提问,系统就能自动生成SQL并查询数据,这极大地降低了数据分析的门槛。然而,喜悦很快被现实冲淡。

我们发现,当用户的提问稍显模糊,或涉及未明确定义的业务术语时,系统的表现便开始“随心所欲”。例如,当用户在未指定数据表的情况下提问“统计各区域的销售额”,系统可能会选错表;当用户使用“同比增长率”这类行业术语时,系统可能只会计算基础的销售额。更危险的是,在一次内部测试中,我们开启了联网搜索功能,希望增强AI的知识广度,结果AI在回答“2018年长三角城市群各省各城市的销售分布地图”时,完全脱离了我们的内部销售数据,一本正经地输出了无效的结论。这正是典型的“AI幻觉”。

这些问题的根源在于,通用大模型缺乏特定业务场景的“约束”和“常识”。它就像一个知识渊博但缺乏具体工作经验的实习生,空有理论,却无法精准地应用于实际业务。初期的准确率徘徊在70%左右,这意味着每三次查询,就可能有一次出错。这样的产品,无法交付给任何一个严肃对待数据的企业。

二、破局之路:从“听得懂”到“做得对”的进化

要终结AI幻觉,唯一的办法就是为AI戴上“镣铐”,让它在严格的规则和丰富的上下文中舞蹈。我们的技术攻坚历程,可以概括为三个阶段的进化。

阶段一:奠定基石(Focus Search & 初始DSL)

我们的起点是领域特定语言(Domain-Specific Language, DSL),也就是强大的Text-to-SQL引擎。这是我们与数据库交互的“官方语言”,确保了所有最终执行的指令都是精确且无歧义的。这是对抗幻觉的第一道防线,保证了AI的输出至少是“语法正确”的。

阶段二:注入灵魂(小慧智能体 & RAG)

为了让AI不仅“语法正确”,更能“语义正确”,我们推出了“小慧”智能体。其核心技术,正是如今广为人知的检索增强生成(Retrieval-Augmented Generation, RAG)。我们为系统构建了一个强大的“知识库引擎”,它包含了:

元数据知识: 所有数据表的结构、字段含义、关联关系。

指标知识: 业务中常用的指标定义,如“同比增长率”、“优质单”等。

行业术语知识: 解析特定行业的专有词汇。

当用户提问时,RAG机制会先在知识库中检索与问题最相关的上下文信息(比如,用户提到“订单金额”,系统就检索出“订单信息表”和“用户基本信息表”),然后将这些信息连同用户的问题一起交给LLM。这相当于为AI提供了一份详细的“解题说明”,引导它在正确的道路上思考,从而实现了从“盲猜”到“有据可依”的跨越。正是在这个阶段,DataFocus实现了无表启动、动态表切换、多表自动关联等智能化功能。

阶段三:建立信任(FocusGPT & 多链路校验)

要达到95%以上的超高准确率,光有RAG还不够,我们还需要一个无懈可击的“质检员”。为此,我们推出了具备更强理解能力的FocusGPT,并配套研发了“多链路校验”机制。这套机制在AI生成最终答案前,会进行三道严格的审查:

语义一致性校验: 反向解析生成的SQL,判断其逻辑是否与用户的自然语言提问意图完全一致。

模式与权限校验: 检查SQL中涉及的表、字段是否存在,以及当前用户是否具备查询权限,从源头杜绝越权和错误访问。

结果合理性校验: (部分场景)对查询结果进行初步的洞察分析,判断是否存在明显不合理的异常值,并提示用户。例如,“小慧分析总结”功能就是这一能力的体现。

通过这套“技术组合拳”,我们成功地构建了一个从理解、生成到校验的闭环系统,将AI幻觉的发生概率降到了最低。

三、技术“组合拳”深度解析

我们的高准确率并非依赖单一技术,而是一个系统工程。以下是我们核心技术的协同工作方式:

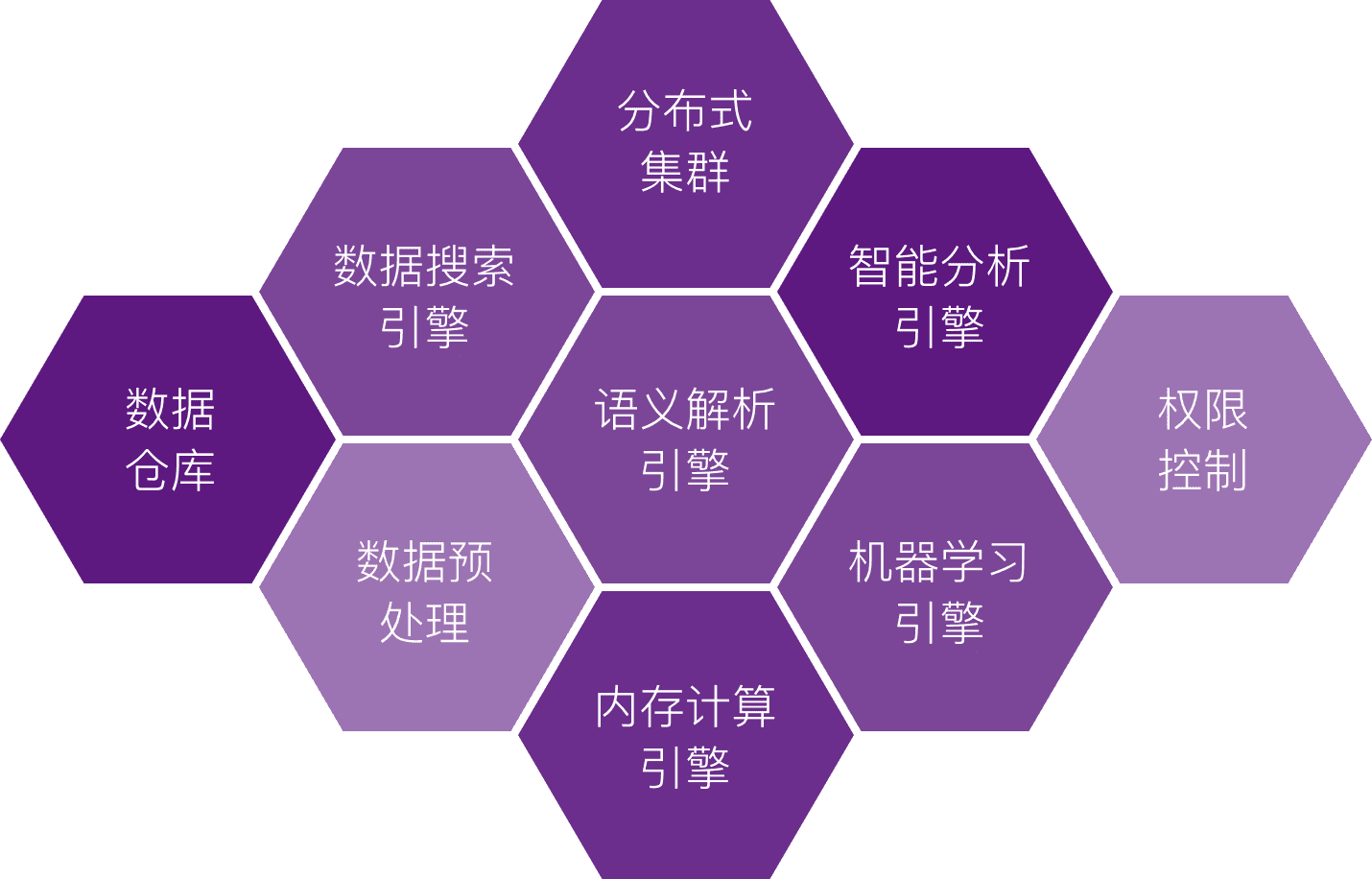

图1: DataFocus 系统架构,展示了语义解析、机器学习等核心引擎

1. 领域特定语言 (DSL):不可动摇的执行基础

我们的核心是自研的Text-to-SQL引擎。它将用户的自然语言精准翻译成数据库可以执行的SQL代码。这是所有分析的基石,确保了AI的“思考”最终能转化为确定性的机器指令,而非模糊的文本描述。

2. 检索增强生成 (RAG):让AI拥有业务“记忆”

我们为AI打造了一个专属的“长期记忆”——知识库。当用户提问“计算各区域的优质单订单数”时,RAG机制会先从知识库中检索出“优质单”的定义(例如,销售额 > 100),然后将这个定义作为上下文注入到LLM中。这使得AI能够理解企业内部的“黑话”,而不是基于通用知识进行猜测。

3. 多链路校验 (Multi-Link Verification):答案的“守门员”

这是我们实现超高准确率的“秘密武器”。在SQL执行前,校验机制会像一位严谨的代码审查员,从语义、模式、权限等多个维度进行检查,确保万无一失。这一机制从根本上解决了AI“信口开河”的问题,保证了输出给用户的每一个数据都是真实、准确、可信的。

四、从“不敢用”到“放心用”:客户的真实声音

技术的最终价值在于客户的认可。在产品准确率达到95%+后,我们收到了许多早期用户的积极反馈。其中一位头部零售企业的客户的评价最让我们振奋:

“以前用其他AI分析工具,感觉像在开盲盒,总得自己把AI生成的SQL拿出来再三检查,生怕有错。现在我才敢把 DataFocus 生成的报告直接发给老板,因为它不仅快,而且准。这为我们团队节省了大量的数据核对时间。”

— 某头部零售企业数据负责人

这句朴素的证言,是对我们技术攻坚最好的回报。它标志着我们的产品真正从一个“炫酷的玩具”转变为一个“可靠的生产力工具”。

| 场景对比 | 优化前 (准确率 ≈ 70%) | 优化后 (准确率 > 95%) |

|---|---|---|

| 模糊查询 | 用户提问“各区域销售额”,可能因无法确定主表而失败或返回错误数据。 | 系统通过语义理解和知识库,自动匹配最相关的“电商销售数据”表,精准返回结果。 |

| 行业术语 | 提问“计算月度同比增长率”,可能仅计算出月度销售额,无法理解“同比增长率”。 | 知识库引擎自动解析“同比增长率”,并生成正确的同比计算公式,直接给出最终答案。 |

| 多表关联 | 提问“不同年龄用户的平均订单金额”,需要用户手动关联用户表和订单表。 | 系统自动识别问题需要“用户信息表”和“订单信息表”,并基于预设或动态发现的关联关系,自动完成多表查询。 |

| 报告生成 | 生成报告后,发现数据有误,需要返回源头重新查询、修改,流程繁琐。 | 一键生成报告,多链路校验机制确保了数据的高度准确性,用户可直接使用或分享。 |

五、结语:信任,是AI在BI领域唯一的通行证

在AI+BI的浪潮中,功能的酷炫和交互的流畅固然重要,但它们都建立在一个脆弱的基础之上——信任。如果用户不能100%信任AI给出的答案,那么再智能的交互也只是空中楼阁。

DataFocus团队的这场“幻觉终结之战”,是一次对技术初心的回归。我们坚信,直面AI应用中最棘手的准确率问题,并用扎实的技术、严谨的逻辑去攻克它,才是建立产品长期价值和客户信任的唯一路径。未来,我们将继续深化这套技术体系,让DataFocus成为每个企业最值得信赖的数据分析伙伴。