作为一名数据分析工程师,我们经常需要从各种各样的源头获取数据,然后进行清洗、转换和加载到最终的数据目的地。这个过程可以称为ETL(Extract-Transform-Load), 即是从数据源中抽取数据,对其进行必要的处理和转换操作,然后将其加载到目标系统中。

ETL技术是在数据仓库和商业智能发展起来以后才逐渐受到关注,并被广泛应用于企业级数据管理过程中。由于垃圾进,垃圾出的道理,数据质量本身就是很重要的。“80%的精力放在数据处理上”已成为行业常识。因此,选择一款高效稳定的ETL工具,既可提升工作效率,减少人为失误,也可以减小了风险。

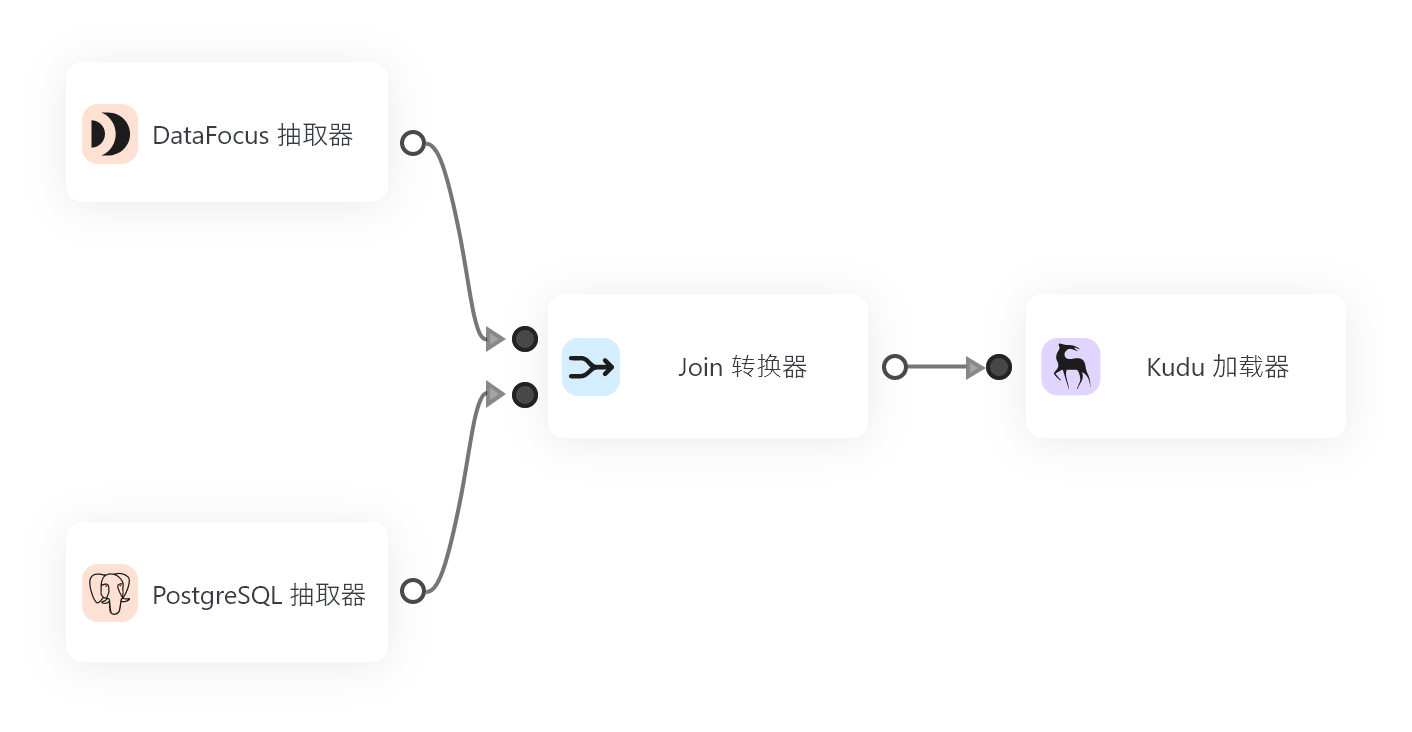

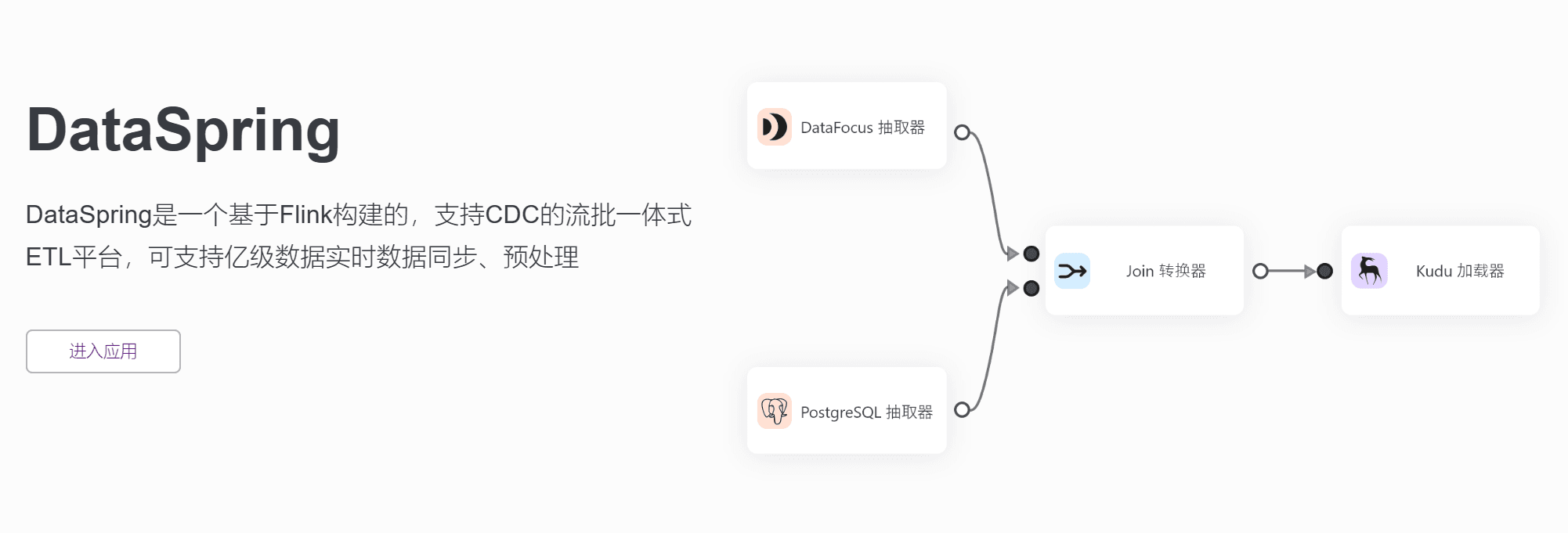

有了这种背景,DataSpring就成为值得研究的一个工具。DataSpring作为一款新型的流批一体化ETL平台,是基于Flink构建的一个支持CDC的工具集,同时支持亿级数据实时数据同步和预处理。 在功能性方面,DataSpring也具备了极高的竞争力。

DataSpring采用基于日志的增量数据获取技术,支持异构数据之间丰富、自动化、准确的语义映射的构建,并支持实时和批量数据处理,因此在运行效率上更具优势。DataSpring具有以下几个优点:

首先是支持多种数据库如Oracle、MySQL、SQL Server、PostgreSQL等的增量同步和转换,同时还支持API数据的增量同步和转换。这对于企业级应用而言是一个非常重要的特性。

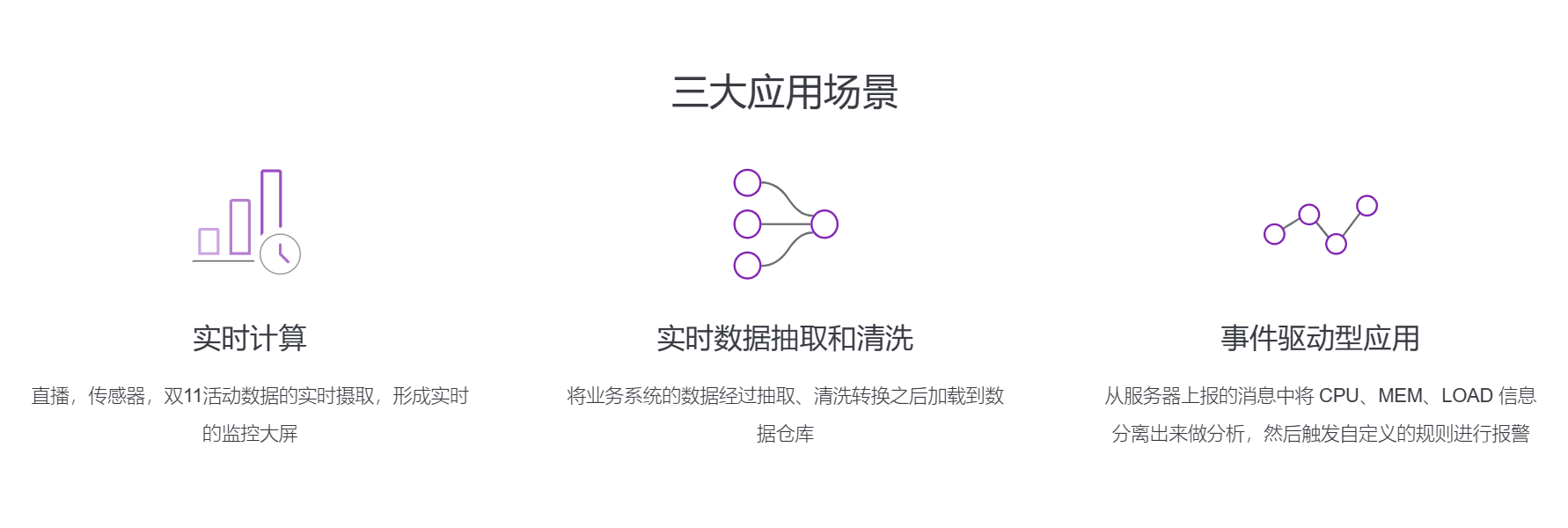

其次,DataSpring具有功能丰富的数据处理模块,其中包括数据接入、批处理任务、流处理任务、公式转换、自定义UDF算子、定时任务等。通过不同的处理模块,DataSpring可以满足不同的数据处理需求,并提供灵活的解决方案。

在架构方面,DataSpring采用了基于事件驱动的设计原则,使得数据计算与分析不再分离,可以本地访问获取数据。相比传统的ETL工具,DataSpring具有更高的吞吐和更低的延迟,并且对于流处理任务和批处理任务达到完美平衡,兼容性也更高。

最后, DataSpring除了能够从服务器上报的消息中将CPU、MEM、LOAD信息分离出来做分析,然后触发自定义的规则进行报警,还可以实现直播、双11活动数据信息的实时摄取,形成实时的监控大屏等功能,更加方便数据分析师进行监控。

从我个人角度看,DataSpring是一个非常不错的ETL工具。相对于传统的ETL工具而言,在数据处理效率上有着显著的提升,同时也具备了更高的灵活性和可扩展性。其基于日志增量导入技术的特点,无论是在同步速度和数据可靠性上都有很好的表现。作为一名数据分析工程师,我们的任务就是让数据变得更有意义,无论是清洗、转换还是加载,DataSpring都可以成为我们削减冗余工作的得力助手。